Word2vec和GloVe的准确率差异

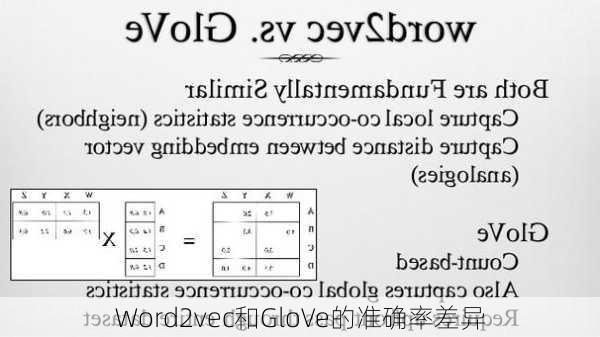

Word2vec和GloVe是两种常见的词嵌入模型,它们都可以将词语转化为数值向量,以便于计算机进行处理。尽管它们的基本理念相似,即根据词汇的共现信息将其编码为向量,但具体的实现方式和应用场景略有不同,从而导致了准确率上的差异。

Word2vec是一种“predictive”的模型,它通过预测上下文来训练模型。Word2vec主要有skipgram和CBOW两种模型。skipgram是给定input

word来预测上下文,比较适合用于大规模的数据集上。cbow是给定上下文,来预测input

word,比较适用于小规模或者内存有限的情况。GloVe(Global

Vectors

for

Word

Representation)则是“countbased”的模型,它首先基于语料库构建词的共现矩阵,然后基于共现矩阵学习词向量。

不采用negativesampling的Word2Vec速度非常快,但是准确率仅有57.4%。这是因为Word2Vec只告诉模型什么是有关的,却不告诉它什么是无关的,模型很难对无关的词进行惩罚从而提高自己的准确率。然而,当使用了negativesampling之后,为了将准确率提高到68.3%,Word2Vec就需要花较长的时间了(8h38m)。

相比之下,GloVe因为更容易并行化,所以速度更快,达到67.1%的准确率,只需要花4h12m。这表明在追求高准确率的情况下,GloVe具有更高的性价比。

由于GloVe算法本身使用了全局信息,自然内存费的也就多一些,相比之下,Word2Vec在这方面节省了很多资源。这意味着在内存有限的情况下,Word2Vec可能是更好的选择。

Word2Vec适合的情况就是对于一个序列的数据,在序列局部数据间存在着很强的关联。典型的就是文本的序列了,邻近的词之间关联很强,甚至可以通过一个词的上下文大概预测出中间那个词是什么。而GloVe在语义类比任务上效果较好。

总的来说,Word2Vec和GloVe在准确率上的差异并不是绝对的,选择哪种模型更适合取决于具体的应用场景和需求。在实际应用中,可以根据项目的实际情况和资源限制来决定使用哪一种模型。