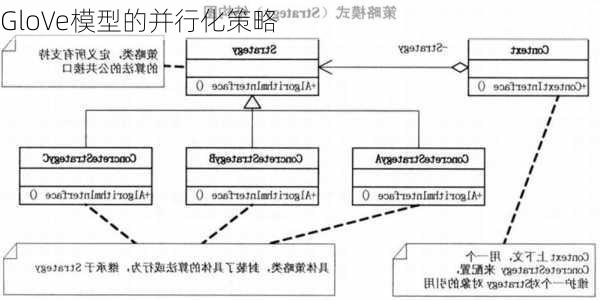

GloVe模型的并行化策略

GloVe(Global

Vectors

for

Word

Representation)是一种常用的词嵌入方法,它的主要目标是通过统计共现矩阵来学习单词的向量表示。这种模型在处理大规模语料库时,采用了并行化策略来提高训练效率。

GloVe模型的核心是构建一个词汇的共现矩阵,每一行是一个单词,每一列是上下文。这个矩阵记录了每个单词在每个上下文出现的频率。在实际应用中,GloVe采用的是Countbased模型,即在建立共现矩阵的基础上,再对上下文进行降维的操作,从而学习到单词的低维向量表示。

在GloVe模型的训练过程中,并行化策略的应用体现在以下几个方面:

1.矩阵分解:GloVe模型通过对共现矩阵进行降维,寻找可以解释高维数据中大部分方差的低维表示。这种降维的思想与PCA(Principal

Component

Analysis,主成分分析)原理类似,即找到可以解释数据中大部分变异性的线性组合。在这个过程中,可以将矩阵分解为多个部分,分别在不同的处理器或计算单元上进行处理,从而实现并行计算。

2.词汇划分:为了进一步提高并行化效率,可以将词汇表划分为多个部分,每个部分分配给一个计算任务。这样,不同的计算任务可以在不同的处理器上同时进行,从而加快整体的训练速度。

3.损失函数优化:GloVe模型的损失函数旨在最小化预测误差。在并行化策略中,可以通过将数据集分成多个子集,每个子集对应一个计算任务,来优化损失函数。这样,多个计算任务可以在不同的处理器上同时进行梯度下降或其他优化算法的迭代,从而加速模型的学习过程。

通过这些并行化策略的应用,GloVe模型能够在处理大规模语料库时,显著提高训练效率和并行计算能力。这使得GloVe成为了一种高效且实用的词嵌入方法。