Word2vec与GloVe的区别详解

1.概念理解

Word2vec和

GloVe都是用于将单词映射到向量空间中的方法,以便于计算机处理和理解自然语言。它们都可以根据词汇的共现信息,将词汇编码成一个向量。然而,它们在实现细节和训练目标上有所不同。

2.训练目标和方法

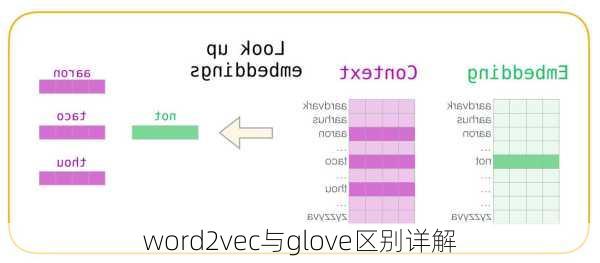

Word2vec是基于局部语料库训练的,其特征提取是基于预测的模型。它通过构建共现信息矩阵,并利用SVD求解来构建词向量。Word2vec的训练过程是对每个单词预测其上下文单词出现的概率,从而得到词向量。

GloVe(GlobalVectors

for

Word

Representation)则是基于全局语料库、并结合上下文语境构建词向量,它是一个基于全局词频统计的词表征工具。GloVe的训练过程是对共现矩阵进行因子分解,找到一个矩阵乘积可以最好地恢复原始的共现矩阵,从而得到词向量。相比于Word2vec,GloVe利用了全局信息,使其在训练时收敛更快,训练周期较Word2vec较短且效果更好。

3.损失函数

在Word2vec

中,损失函数通常是交叉熵损失。而在GloVe

中,损失函数是对原始共现矩阵进行因子分解后的残差平方和,这个损失函数可以更好地捕捉全局的统计信息。

4.优缺点比较

Word2vec在捕捉语法信息方面表现较好,但缺乏全局的统计信息,在语义相关性方面有所不足。而GloVe

则能较好地使用到全局的统计信息,并在一定程度上结合了窗口机制的优点,但在捕捉语法信息方面相对较弱。

5.应用场景

由于它们各自的特点,Word2vec

和

GloVe在不同的应用场景下可能会有不同的表现。例如,在需要考虑语法信息的任务中,Word2vec可能是更好的选择;而在需要考虑全局统计信息的任务中,GloVe可能更适合。

总的来说,Word2vec和GloVe都是非常有效的词向量生成方法,它们各有优势和适用场景。在选择使用哪种方法时,需要根据具体的任务需求来决定。