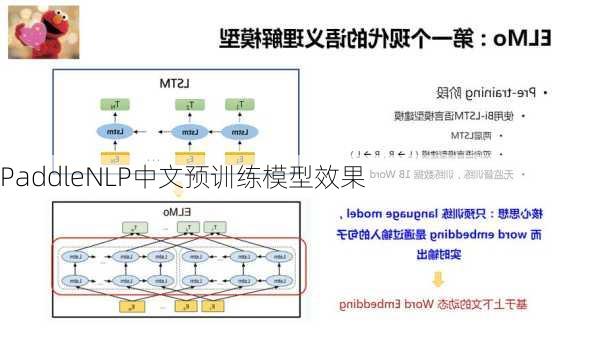

PaddleNLP中文预训练模型效果

1.实现的预训练模型

PaddleNLP库实现了多种预训练模型,其中包括了NeZha模型。NeZha是一个面向中文NLU任务的模型,它是基于BERT模型开发,并进行了多处优化。这些优化包括了函数式相对位置编码、全词掩码训练、混合精度训练以及在训练过程中使用LAMB优化器。

2.ERNIE系列模型的表现

ERNIE系列模型是基于飞桨开源的持续学习的语义理解框架,以及基于此框架的ERNIE2.0预训练模型。ERNIE2.0在共计16个中英文任务上超越了BERT和XLNet,取得了SOTA效果。尤其是在中文任务中,ERNIE2.0全面超越BERT,这表明PaddleNLP的中文预训练模型在各种任务中都有出色的表现。

3.应用研究案例

PaddleNLP在情感分析竞赛中的应用研究是一个很好的例子。在这个研究中,使用PaddleNLP的Skep预训练模型实现了千言数据集——情感分析比赛。这个研究表明,PaddleNLP的预训练模型在实际应用中也能发挥很好的效果。

4.开源代码和模型

为了方便其他人使用和进一步研究,ERNIE2.0的Finetuning代码和英文预训练模型已经开源。这表明PaddleNLP的预训练模型不仅在效果上优秀,而且在开放性和可扩展性上也做得很好。

综上所述,PaddleNLP的中文预训练模型在各种任务中都展现出了很强的实力,无论是理论效果还是实际应用,都能满足需求。