word2vec是一种基于预测的模型,它的训练方式有两种,一种是Continuous

Bag

of

Words(CBOW),另一种是SkipGram。CBOW通过上下文预测中心词,而SkipGram则是通过中心词预测上下文。word2vec的训练过程可以用一个简单的前馈神经网络进行,隐层向量就是我们希望得到的词向量。

GloVe:

GloVe是一种基于计数的模型,它的构建过程是构建一个词汇的共现矩阵,每一行是一个word,每一列是context。GloVe的计算过程考虑到了全局的统计信息,计算GloVe词向量时,首先计算出一张全局的词汇共现矩阵,也就是不同单词同时出现的次数,再根据论文中的计算方式分解后得到词汇的特征向量。2.训练方式word2vec:

word2vec的训练过程是通过神经网络进行的,它使用了梯度下降法等优化算法来最小化损失函数,从而得到词向量。

GloVe:

GloVe的训练过程是对共现矩阵进行降维,这一过程可以被视为共现矩阵的重构问题,即reconstruction

loss。找到能够解释高维数据大部分方差的低维表示是PCA的原理。3.模型性能word2vec:

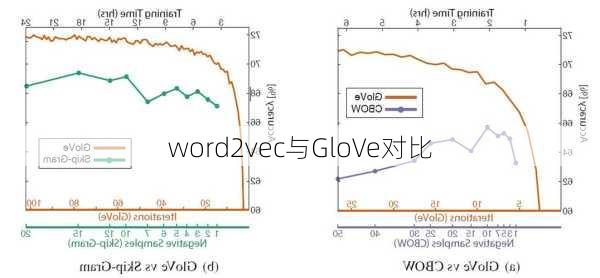

word2vec在处理局部语料方面表现优秀,它的优点和GloVe几乎一样,同样能体现语义信息,最大的区别在于训练方式不同。

GloVe:

GloVe利用了全局信息,使其在训练时收敛更快,训练周期较Word2vec较短且效果更好。4.并行化能力

word2vec:

word2vec在并行化上有一些困难。

GloVe:

GloVe更容易并行化,所以对于较大的训练数据,GloVe更快。

总的来说,word2vec和GloVe都是目前比较流行的词向量模型,它们各有优缺点,适用于不同的场景。用户可以根据自己的需求选择合适的模型。