回归模型性能优化方法

在机器学习中,回归模型的性能优化是一个重要的环节,其目的是通过一系列的优化方法,使模型在训练集和测试集上的表现达到最优。以下是几种常见的回归模型性能优化方法:

1.均方误差(MSE)最小化

均方误差(MSE)是回归模型中最常用的评价指标,它是预测值与真实值之间差值的平方的平均数。在训练过程中,我们通常会尽量减小MSE,以提高模型的预测准确性。然而,仅仅关注训练集上的MSE是不够的,因为我们更关心模型在面对未知数据时的表现,即测试集上的MSE。因此,我们的目标是找到一个能够在测试集上最小化MSE的模型。

2.偏差方差权衡

在优化过程中,我们需要注意偏差方差的权衡。增加模型的复杂度可以减少偏差,但同时会增加方差。我们的目标是找到一个既能减小偏差又能控制方差的模型。一种常见的方法是对训练误差进行修正,或者使用交叉验证来直接估计测试误差。

3.子集选择

子集选择是一种有效的优化方法,它涉及到从原始特征集中选择最优的特征子集来建立模型。通过不断地增加或减少特征,我们可以找到一个具有最小测试误差的模型。这个方法可以帮助我们避免过拟合和欠拟合的问题,提高模型的泛化能力。

4.压缩估计(正则化)

压缩估计是一种通过添加惩罚项到损失函数中来优化模型的方法。例如,在岭回归中,我们在线性回归的损失函数上添加了一个对系数的约束,从而使得模型的系数趋向于0,降低了方差。类似地,Lasso回归使用L1范数替换L2范数,可以在某些情况下实现特征提取。

5.降维

降维是一种通过减少特征数量来优化模型的方法。主成分分析(PCA)是一种常用的降维技术,它的目标是通过最大化投影方差来重构原始空间。通过PCA,我们可以找到一组新的不相关的特征,这些特征可以更好地代表原始数据的空间结构。

6.自变量选择

自变量选择是指在建立回归模型时,从众多可能的自变量中选择最相关的变量来建立模型。这不仅可以提高模型的预测准确性,还可以降低模型的复杂度,减少过拟合的风险。自变量选择的方法包括前进法、后退法以及基于信息量的模型选择准则。

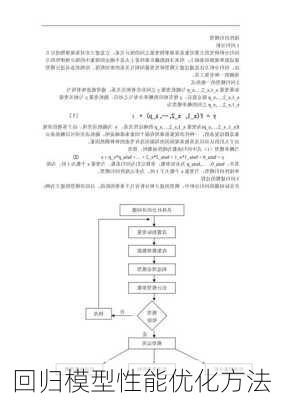

7.参数优化算法

除了上述方法外,我们还可以使用各种参数优化算法来求解回归模型的最优参数。例如,梯度下降法、牛顿法和拟牛顿法等都是常用的优化算法。这些算法通过迭代的方式来最小化损失函数,从而找到最优的模型参数。

以上就是一些常见的回归模型性能优化方法,实际应用中可能会结合多种方法来获得更好的优化效果。