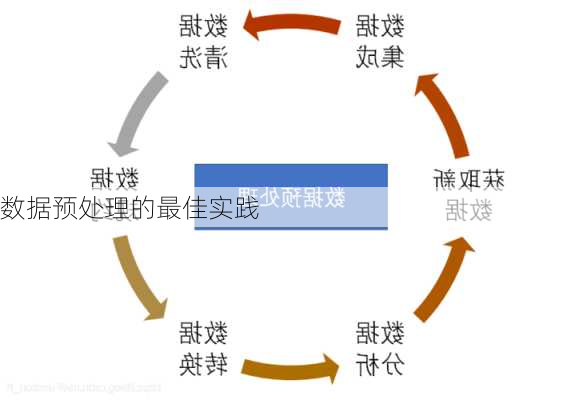

数据预处理的最佳实践

数据预处理是数据分析过程中不可或缺的一步,它的目的是为了提高数据的质量和可用性,以便后续的数据分析和建模。以下是根据给定的搜索结果总结出的一些数据预处理的最佳实践。

1.数据清洗

数据清洗是数据预处理的第一步,主要是去除数据中的噪声、异常值和缺失值。可以使用统计方法、数据挖掘算法等对数据进行清洗,以保证数据的准确性和一致性。

2.处理缺失值

处理缺失值是数据预处理中的一个重要环节。常见的处理方法有删除记录、均值填充、中位数填充等。在进行缺失值处理时,应尽可能地使用最可能的值代替缺失值,使缺失值与其他数值之间的关系保持最大。

3.异常值处理

异常值是数据集中偏离大部分数据的数据。从数据值上表现为:数据集中与平均值的偏差超过两倍标准差的数据。异常值的处理方法包括删除异常值和替换异常值。删除异常值的方法适用于异常值数量较少的情况,替换异常值的方法适用于异常值数量较多的情况。

4.数据转换

数据转换是将原始数据转换为适合进一步分析的形式。例如,特征二元化是将数值型的属性转换为布尔值的属性,设定一个阈值作为划分属性值为0和1的分隔点。独热编码则是将分类数据编码为数值数据,便于在模型中使用。

5.数据标准化和正则化

数据标准化的原因是:某些算法要求样本具有零均值和单位方差;需要消除样本不同属性具有不同量级时的影响。常见的数据标准化方法有zscore标准化和最小最大规范化。数据正则化是将样本的某个范数缩放到到位1,正则化的过程是针对单个样本的,对于每个样本将样本缩放到单位范数。

6.特征选择

特征选择是从给定的特征***中选出相关特征子集的过程。进行特征选择的两个主要原因是:减轻维数灾难问题;提高模型的解释性和预测精度。

7.使用适当的数据预处理工具

在进行数据预处理时,应选择适合的工具。例如,Python的pandas库提供了丰富的数据处理功能,可以方便地进行数据清洗、转换和集成。

以上就是数据预处理的一些最佳实践,希望对您有所帮助。