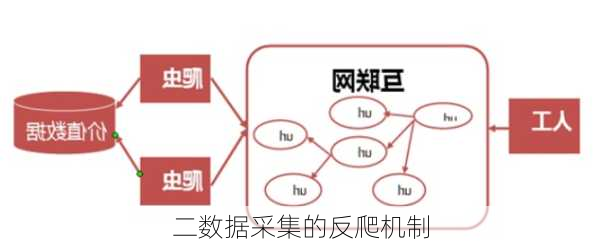

数据采集的反爬机制

数据采集的过程中,网站通常会采取一系列的反爬机制来防止爬虫程序的过度访问和数据的无序抓取。这些反爬机制主要包括以下几个方面:

网站会检查用户请求的Headers,特别是`UserAgent`、`Referer`和`Cookies`这几个字段。`UserAgent`是用来表示请求者的信息,很多网站使用它来作为识别爬虫的标志。如果访问请求的头部中没有带`UserAgent`,那么就会被判定为爬虫。`Referer`字段可以使用浏览器分析提取referer信息,需要登录才能操作的页面可以保留`Cookies`,带着`Cookies`信息登录。

爬虫为了保证效率,往往会在很短的时间内多次访问目标网站,所以可以通过单个IP访问的频率来判断是否为爬虫。并且,这种反爬方式比较难以被反反爬机制反制,只能通过更换代理IP来保证效率。

验证码完全是随机的,爬虫脚本无***确识别,同样可以限制爬虫程序。对于网站有验证码的情况,我们有三种办法:使用代理,更新IP;使用cookie登陆;验证码图片识别:利用开源的TesseractOCR系统进行验证码图片的下载及识别,再将识别的字符传到爬虫系统进行模拟登陆。

一部分网站是通过检测用户行为,例如同一IP短时间内多次访问同一页面,或者同一账户短时间内多次进行相同操作。对于这种情况,使用IP代理就可以解决。还有一些网站,我们需要爬取的数据是通过ajax请求得到,或者通过JavaScript生成的。这种情况下,我们需要使用如Selenium+PhantomJS框架等工具,调用浏览器内核,并利用PhantomJS执行js来模拟人为操作以及触发页面中的js脚本。

以上就是数据采集过程中常见的反爬机制,以及相应的应对策略。需要注意的是,反爬机制是网站方为了避免数据被爬取,增加了各种各样的反爬虫措施。因此,网络爬虫的难点在于反爬的攻克和处理。