数据采集效率优化方法

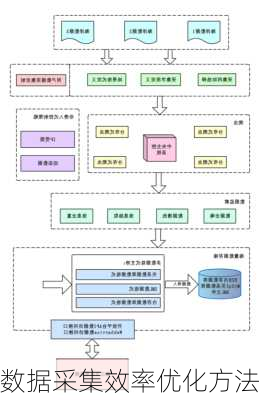

数据采集效率的优化是一个复杂的过程,涉及到多个方面的技术和策略。以下是一些主要的优化方法:

数据查询是数据采集和分析的核心部分,因此优化数据查询非常重要。一些优化方法包括索引优化、查询优化和缓存优化。索引优化可以帮助加快查询速度,查询优化可以避免不必要的操作导致的查询效率下降,而缓存优化则可以减少重复查询对数据库性能的影响。

数据分区是一种将大型数据集分解为更小、管理良好的块的技术。水平分区和垂直分区是两种常见的数据分区方式。水平分区通常将数据按行分成多个分区,而垂直分区则将数据按列分成多个分区。此外,选择正确的分区键也是优化数据分区性能的关键。

数据压缩技术可以在存储和传输数据时更有效地利用资源。通过选择正确的压缩算法、文件格式和压缩级别,可以提高数据压缩的效率,同时减少相关的时间和成本。

使用代理服务器与IP轮换策略可以规避风险并顺利获取网络数据。代理服务器能够为用户提供多个IP地址,涵盖不同地理区域或设备,这使得用户能够发起大量的并发请求。同时,设置用户代理标头也可以使爬虫请求看起来更像是来自真实用户的请求。

对于需要大量获取数据信息的场景,单个线程的爬取网页数据会达到极限。此时,可以使用分布式爬虫,通过多台机器并发爬取数据,有效提高采集效率。

优化数据采集流程可以避免在同一个页面频繁访问,减少触发网站反爬机制的风险。同时,进行去重处理也是非常重要的,可以避免对已爬取过的页面再次进行抓取。

数据质量问题是数据采集中的难题。通过建立明确的数据质量标准、加强数据采集过程的管控、优化数据处理和清洗等方面的建议,可以有效地提升数据质量,保证数据采集工作的准确性和有效性。

以上就是提高数据采集效率的一些主要方法。在实际应用中,可以根据具体的需求和场景,综合运用这些方法,以实现最优的数据采集效率。